Comunicación presentada al IV Congreso Smart Grids:

Autores

Resumen

Una de las prioridades de una plataforma de gestión y muy especialmente en entornos empresariales e industriales heterogéneos, es optimizar la gestión y procesamiento de la información de diferentes elementos en tiempo real, con objeto de facilitar, agilizar y perfeccionar el control y la toma de decisiones. Keytron y Aerin proponen la creación de una plataforma multipropósito basada en una tecnología asequible y fácil de usar, que permita disponer de la información de diferentes elementos en tiempo real. El tratamiento de dicha información se llevará a cabo mediante el uso de algoritmos predictivos capaces de ofrecer detalles adicionales que favorezcan y ayuden en la toma de decisiones. El entorno IoT en el que se desarrollará estará completamente securizado garantizándose así la integridad de los datos en tiempo real.

Introducción

Tradicionalmente en el entorno de la telemetría y la gestión de sistemas se han estado utilizando soluciones de gestión complejas y, en muchos casos, propietarias de cada fabricante. Por ello la interoperabilidad de la información obtenida de diferentes dispositivos es más difícil de tratar. La plataforma que se presenta a continuación garantiza de forma sencilla y en un entorno seguro, la disponibilidad de la información en tiempo real de múltiples dispositivos en el entorno IoT, y permite un tratamiento predictivo para la toma óptima de decisiones.

Descripción de la Solución

Con el desarrollo de esta solución se pretenden obtener los siguientes resultados:

- Hardware Multipropósito. Proponer una plataforma que recoja la información de distintos tipos de sensores o elementos con conexiones particulares.

- Plataforma securizada. Una cuestión básica en una plataforma de gestión es asegurar que el tratamiento de la información que proporcionan los datos gestionados no se vea amenazada y sea realizado de la manera más segura posible; en paralelo que esté asegurado todo el entorno y elementos gestionados. Especialmente es importante en plataformas orientadas a gestiones diversas donde toda la cadena de gestión debe ser segura. Dicha plataforma será:

- Segura y Confiable: Cuando se pretende gestionar recursos que deben proteger bienes, infraestructuras y/o personas, se tiene que poder confiar en la seguridad de un acceso mantenido en el tiempo, que consideremos la no existencia de fallos que puedan interrumpir ver peligrar los sistemas.

- Ofrecer alta disponibilidad y que los motores de monitorización sean dedicados para que los requerimientos y posibilidades sean siempre los más avanzados, de modo que la protección de los datos y de la operación sea máxima.

- Escalable: Cualquier utilización de una Plataforma debe ser considerada como si las necesidades fuese las exigentes del mundo. La arquitectura de la Plataforma debe facilitar y asegurar que el sistema (tanto el de gestión como el gestionado) pueda crecer las necesidades de cada momento, ofreciendo la mejor y mayor escalabilidad de forma inherente al propio sistema; siempre con una total garantía de seguridad.

- Accesible: Es imprescindible que el manejo y control de la Plataforma esté asegurado en cada momento, por lo que debemos construirlas e implantarlas en los entornos más accesibles y fáciles de usar para acceder y controlar las funciones de forma directa y precisa, como Pc´s, Smartphone, tablets, etc.

- Orientado al trabajo en tiempo real y realizable desde cualquier lugar (operadores y responsables de operación puedan trabajar sobre ella y gestionar alertas, alarmas y/o mensajes de forma inmediata).

- Recogida de datos: permite la conexión a distintos dispositivos para la recogida de datos, pudiendo ser sensores (temperatura, humedad, PH, presión, etc.), autómatas, analizadores de redes, centralitas de captura y procesamiento de datos, elementos de visión artificial, etc.

- Procesado de datos: Una vez capturados los datos, es necesario procesarlos de distintas maneras para extraer información útil de ellos.

- Cálculo de variables basadas en datos adquiridos.

- Almacenamiento y reporte de datos: Almacenamiento a largo plazo de datos capturados y calculados que permita la consulta de varias maneras: Graficado, informes resumen, listados, etc.

- Interfaz de usuario: Permite la interacción del usuario con el sistema. Desde el interfaz, el usuario podrá ajustar parámetros, consultar informes, visualizar gráficas y, en general, ver y manipular el estado del sistema en tiempo real.

- Capa de seguridad: Que facilite la integridad de los datos y del sistema de monitorización, que disminuya el tiempo de tratamiento antes posibles incidencias.

- Manejo Web con elementos comunes y seguros para la gestión de usuarios, permitiendo construir aplicaciones a medida de las necesidades de los clientes con un bajo coste.Framework de desarrollo. Permitirá interactuar con múltiples aplicaciones pues los mundos empresariales e industriales son muy heterogéneos. Posibilitará la integración de dispositivos de múltiples fabricantes, con distintos protocolos y tipos de señales, etc. Las partes elementales comunes serán:

- Administración de todos los dispositivos desde un punto centralizado. Esta administración debe ser en formato HHTP y directamente a la pantalla de administración

- Accesos seguros por VPN a los equipos.

- Almacenamiento de todos los datos y posibilidad de tratamiento de los mismos con modelos de Datamining e Inteligencia Artificial; implementando técnicas de predicción y optimización con dos finalidades: Monitorizar, y Predecir.

- Realización sencilla, dinámica y automatizada de informes y Dashboards/cuadros sinópticos con datos de uno o varios dispositivos.Software en la nube y desarrollo de algoritmos predictivos. Con el análisis predictivo de la información que permita escoger el algoritmo adecuado en cada momento los equipos enviarán todos los datos al Servicio en Cloud, cuyas funcionalidades son:

- Visión general. Una de las más importantes funciones de una Plataforma es poder ofrecer una imagen general de la situación, para ello es imprescindible que proporcionen:

- Monitorización centralizada, toda la información se manejará en tiempo real y estará disponible en cualquiera de los puntos considerados, locales y remotos, con una única Interface.

- Mapas dinámicos e interactivos, para facilitar el acceso a cualquiera de las necesidades tanto de monitorización como de gestión, asegurando que la visión sea lo más veraz posible

- Informes precisos y consolidados, como valor añadido para que poder diagnosticar, encontrar y finalmente resolver una incidencia y/o necesidad; de forma sencilla y rápida, desde cualquier lugar donde se haya previsto poder hacerlo.

Metodología

Se utilizará un hardware multipropósito para que el desarrollo de un Framework y de la aplicación de algoritmos permitan un comportamiento predictivo en función de las características de los datos que se tengan.

Desarrollo de hardware

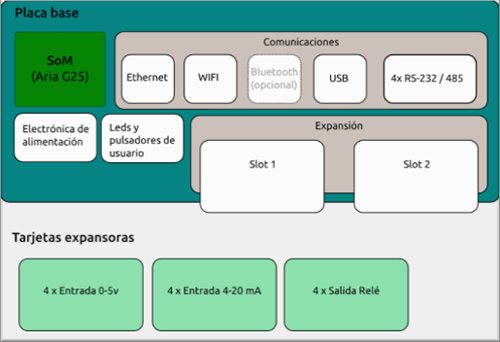

El hardware que se fabricará se diseñará con tarjetas expansoras (“huecos” que tendrá el equipo en los que se pueden conectar tarjetas que permitirán añadir módulos al hardware para poder poder cubrir cualquier necesidad de un cliente).

Emplea hardware estándar de mercado con el objetivo de permitir, facilitar y asegurar:

- Conectividad con protocolos industriales: Soporte de RS-485, CanBus, RS-232.

- Conectividad estándar: Wifi, Ethernet, Bluetooth.

- Capacidad de expansión I/O: Debe aceptar la inclusión de nuevas entradas y salidas con distintos tipos de señal, según los requerimientos específicos de cada proyecto.

- Bajo consumo energético: Podrá ser alimentado con baterías y/o paneles solares si fuese necesario.

- Economía de escala: El coste de compra debe ser es inferior al coste de fabricación específica.

- Simplificación de nuestro diseño: Ofreciendo un diseño con ahorro de costes y garantía de funcionamiento.

- Modularidad: En función de las necesidades del proyecto.

- Soporte: El fabricante debe poder proporcionar una gran cantidad de documentación de gran calidad, poseer foro de usuarios on-line, y un contacto directo con un servicio de soporte.

- CPU de fabricante conocido: Que facilita y proporciona herramientas gratuitas y documentación abierta para los desarrollos.

La solución adoptada consiste en la combinación de un SoM + Placa base complementada por tarjetas expansoras que permitirán adaptar el producto a las necesidades específicas de cada proyecto. Estableciendo una analogía con un cuerpo humano, podemos entender el SoM como el cerebro, la placa base como el tronco y las tarjetas expansoras como los brazos y piernas.

Seguridad de la plataforma, Blockchain

Es imprescindible que la Seguridad sea un proceso continuo y real, que se pueda confiar en todo momento en la integridad de lo que se está monitorizando, estudiando y/o resolviendo.

Cuando se genera un documento se hace con un convenio previo de cómo realizarlo, cómo tratarlo, cómo entenderlo y cómo y dónde guardarlo; este mecanismo es una cadena, donde en cada momento se va cerrando con un candado. Desde el primer momento donde se mira, después quien lo maneje y gestione y luego quien lo cierre; pero para que alguien más se sume a este mecanismo se deben abrir primero los tres candados anteriores, para permitir que más miren y manejen, pero a la vez que no puedan cambiar lo que ya está cerrado o consolidado. El documento es único, pero cada vez que alguien lo maneja hay más candados y hay múltiples testigos. Cada nueva operación con el documento hace que este esté protegido por más candados, Blockchain. Y en caso de fallo habría demasiados testigos para firmar el documento. Esto es una cadena de bloques.

A su vez esta cadena está proporcionada por una tecnología que busca aunar criptografía y colaboración para asegurar las operaciones. Movimiento de cadena de valor:

- El documento o dato se realiza en blockchain y cada paso del proceso se debe cumplir.

- Cada paso cumplido se certifica y en el documento genera un nuevo bloque una vez que todas las condiciones se han cumplido.

- En cada movimiento existe un hash, que es parte de la encriptación del anterior y que es registrado y a la vez almacenado; reescribiendo hacia los siguientes, aunque nunca sobre lo ya escrito. Asegurando que no se modifique la información o el dato tratado.

- Cada movimiento o acción que se ha realizado se encripta para imposibilitar que pueda tocar o actuar quien no esté autorizado. Se obtiene un sistema menos vulnerable, ya que cada bloque nuevo se encripta sobre la encriptación anterior.

El Framework

La arquitectura del Framework se basará en el sistema de almacenamiento local (clave-valor) y el conjunto de módulos independientes que actúan en torno a él. Cada módulo realiza una tarea concreta. El concepto de modularidad se mantiene para todas las tareas del sistema. La red de comunicación será otro módulo que podrá propagar diferentes cambios a otros dispositivos interconectados. Esta configuración de red descentralizada es otro de los puntos importantes del sistema, ya que la caída de un dispositivo no afecta al funcionamiento autónomo del resto (de la misma forma que la caída de un módulo dentro de un dispositivo no afecta al resto). Esta característica permite que el sistema sea altamente escalable, diferenciándose de otras soluciones existentes generalmente basadas en un elemento centralizado (bróker) que recibe todas las notificaciones de los dispositivos y las reenvía a los suscriptores. La caída del bróker en un sistema de este tipo implicaría la detención del sistema por completo.

La tecnología del Framework estará en continuo desarrollo de manera que para cada nueva necesidad que se presente se pueda desarrollar una aplicación o desarrollar nuevas aplicaciones con las que conseguir mejoras. Comprenderá dos áreas bien diferenciadas:

- Smart Engine. Conjunto de módulos software que realizan las siguientes labores:

- Adquisición y procesamiento de datos: Alarmas, eventos, manipulación algorítmica, lógica de negocio de la aplicación, etc.

- BB.DD. Histórica: Histórico de datos adquiridos por el sistema y de las variables calculadas en función de los mismos.

- Comunicaciones: Sincronización con sistemas remotos e integración con protocolos de terceros.

- Web Engine. Conjunto de módulos software que realizan las siguientes labores:

- Representación de datos en entornos WEB: Consolas SCADA, Graficado en tiempo real e histórico, etc.

- Configuración de parámetros y generación de informes.

- Editor gráfico para construir pantallas a medida.

Algoritmos predictivos

En el desarrollo del Framework una de las facetas más importantes es la aplicación del análisis predictivo que permita escoger el algoritmo más idóneo en cada momento para dar la respuesta más adecuada. Hacerlo mediante la búsqueda de normas de clasificación o de predicción basadas en los datos, de manera que se prediga o clasifique el resultado futuro de una o más variables de respuesta o de destino, en relación con lo que ocurre en la práctica, con los motivos que la causan o bien en relación con las variables de entrada. El mantenimiento predictivo (también conocido como pronóstico de estado o supervisión de estado de equipos) hace referencia a la supervisión inteligente del equipamiento a fin de evitar fallos futuros. Al contrario que el mantenimiento preventivo convencional, el programa de mantenimiento no está determinado por un cronograma prescrito; en su lugar, se establece mediante algoritmos analíticos que utilizan los datos recopilados por los sensores de los equipos. Este mantenimiento ofrece las siguientes ventajas para los clientes y los fabricantes de equipamiento:

- Reducción del tiempo de inactividad de los equipos gracias a la identificación de los problemas antes de que se produzcan fallos, lo que permite una planificación idónea de las tareas de revisión y el aumento de la vida útil del equipamiento.

- Determinación automática de la causa raíz del fallo, lo que permite la realización de las reparaciones apropiadas sin necesidad de destinar recursos a establecer un diagnóstico.

- Ahorro de costes por tareas de mantenimiento innecesarias.

El modelo predictivo de tablas

- La tabla de aprendizaje: o tabla de entrenamiento con la que “entrenamos” el modelo. En ella se generará el modelo con algún algoritmo.

- La tabla de testing: donde se aplica el modelo generado para poder medir la calidad del mismo y saber si está prediciendo correctamente, comparando la tabla de aprendizaje con la tabla de testing.

Para la determinación del modelo predictivo se seguirá un orden estructurado en torno a tres acciones:

- Definir los objetivos del modelo predictivo.

- Seleccionar los datos que se van a emplear.

- Determinar los algoritmos a aplicar para el análisis predictivo.

No todos los algoritmos de un modelo predictivo tienen la misma función, por ello se emplearán algoritmos cuyo objetivo sea mejorar los algoritmos existentes mediante el “aprendizaje” y algoritmos que provean de nuevas capacidades.

Resultados y datos obtenidos

El desarrollo permitirá la creación de un sistema Cloud capaz de trabajar con varios algoritmos de predicción de forma automática. Un software recogerá los datos y los validará a través de diferentes algoritmos predictivos para poder decidir en tiempo real cuál es el más adecuado.

Los equipos IoT enviarán todos los datos a un Servicio en Cloud que tendrá las siguientes funcionalidades:

- Administración de todos los dispositivos desde un punto centralizado. Esta administración será accediendo por HHTP a la pantalla de administración del equipo IoT.

- Acceso por VPN al equipo de IoT y al PLC.

- Almacenamiento de todos los datos y posibilidad de tratamiento de los mismos con modelos de Dataminig e Inteligencia Artificial (uso de técnicas de predicción y optimización)

- Realización de informes y Dashboards/cuadros sinópticos con datos de uno o varios dispositivos.

Conclusiones

La plataforma propuesta, basada en la fabricación propia de un hardware multipropósito y el desarrollo de un Framework, así como la aplicación de los diferentes algoritmos anteriormente expuestos (que permiten un comportamiento predictivo en función de las características de los datos de origen) permitirá la creación de un sistema Cloud que dispondrá de la información recogida y obtenida de forma predictiva para la toma de decisiones en tiempo real, todo ello, sin perder de vista la ciberseguridad en todo el proceso.

Referencias

- https://blogs.technet.microsoft.com/machinelearning/2016/04/19/evaluating-failure-prediction-models-for-predictive-maintenance

- http://www.forbes.com/sites/louiscolumbus/2016/06/26/10-ways-machine-learning-is-revolutionizing-manufacturing/#5ab12ebc2d7

- https://www.ke.tu-darmstadt.de/lehre/arbeiten/master/2015/Jahnke_Patrick.pd

- http://www.tcs.com/SiteCollectionDocuments/White%20Papers/Machine-Learning-Analytics-in-Manufacturing-0714-1.pdf